Временното спиране или забавяне на глобалния достъп до все по-мощни изчислителни ресурси може да е начин да се спечели повече време за човечеството в лицето на потенциално опасна форма на изкуствен интелект.

Това заяви съоснователят на Ethereum Виталик Бутерин, цигиран от Coin Telegraph. Още от ноември 2023 г. той застъпва идеята, че суперинтелигентният AI може да се появи само след пет години и не може да се каже дали резултатът ще бъде положителен.

Според Бутерин, една евенуална „мека пауза“ в развитието на компютърния хардуер в индустриален мащаб може да бъде опция за забавяне на развитието на AI. Ако това се случи, обществото може да се подготви за потенциалните заплахи.

Суперинтелигентността на AI е теоретичен модел, който обикновено се определя като много по-интелигентен от най-брилянтните хора във всички области на експертиза.

Много експерти и изследователи изразяват загриженост относно изкуствения интелект, като над 2600 настояха в отворено писмо от март 2023 г. да се спре временно развитието му поради „дълбоки рискове за обществото и човечеството“.

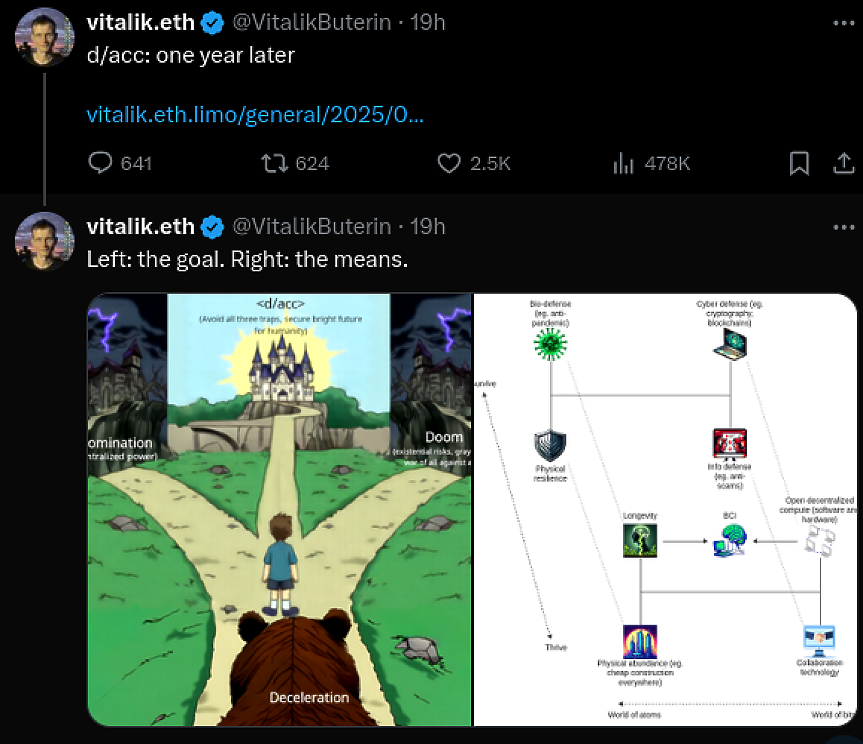

Бутерин отбеляза, че неговият пост отпреди малко повече от година прави само „неясни призиви да не се създават рискови форми на суперинтелигентност“, но сега иска да сподели мислите си за справяне със сценарий, в който рисковете са много по-високи.

Бутерин настоява за доказателства, че тези, които използват, внедряват или разработват AI, могат да бъдат съдени за евентуални щети, причинени от моделите им.

Той отбелязва, че предложенията за "хардуерна пауза" включва идентификация на местоположението на AI чиповете и въвеждане на изискване за тяхната регистрация.

Бутерин предлага индустриалният AI хардуер да бъде снабден с чип, който да му позволява да продължи да работи, само ако е получил три подписа от големи международни регулаторни органи веднъж седмично.

„Подписите ще бъдат независими от устройството и дори верифицирани в блокчейн система", казва съоснователят на Ethereum.

Новините на Darik Business Review във Facebook , Instagram , LinkedIn и Twitter !

Калкулатори

Най-ново

Андраш Сабо: Wizz Air не планира да пуска редовни полети до САЩ

преди 1 часБългария на 4-о място в света по поскъпване на имотите

преди 2 часаПоследен ден с левове: Какво следва след 31 януари?

преди 2 часаГодишната печалба на Bosch се е сринала с 45%

преди 2 часаКолко струват хлебната и фуражната пшеница на борсата у нас?

преди 3 часаЛесно ли е да си намериш работа в България?

преди 3 часаПрочети още

Проф. Стоянов: Радев изпусна момента!

darik.bgХалаф: САЩ удари първо Ливан, след това Сирия, след това Венецуела, сега е ред на Иран!

darik.bgВаня Григорова с разкрития за мафията!

darik.bgКатрин О’Хара почина на 71 - остава завинаги в сърцата като майката от „Сам вкъщи“

9meseca.bg